Większość ludzi, i to nie tylko w rozwiniętych krajach świata zachodniego, zdążyła się już chyba przyzwyczaić do rozmawiania z komputerem. Zarówno za pomocą klawiatury, jak i głosu. „Alexa”, „OK Google”, „Hej Mercedes” i tym podobne hasła stają się codziennym elementem życia wielu społeczeństw. Oprócz rozpoznawania naturalnej ludzkiej mowy komputery zyskują jednak kolejną umiejętność – detekcję emocji użytkownika. Co więcej, same zaczynają zachowywać się… emocjonalnie.

Wystarczy kilka słów

Cyfrowa maszyna może doskonale rozpoznać, jaki aktualnie nastrój ma jakaś osoba. Wystarczy do tego nawet niedługa chwila słuchania. Tak przynajmniej twierdzą eksperci z Instytutu Rozwoju Człowieka im. Maksa Plancka.

„Pokazaliśmy, że uczenie maszynowe może być wykorzystane do rozpoznawania emocji nawet z krótkich klipów audio, trwających zaledwie 1,5 sekundy” – mówi współautor nowego oprogramowania dr Hannes Diemerling. „Nasze modele osiągnęły dokładność podobną do ludzkiej podczas kategoryzowania pozbawionych sensu zdań z emocjonalnym zabarwieniem wypowiadanych przez aktorów” – podkreśla.

W nagraniach zawarto takie emocje jak radość, gniew, smutek, strach, obrzydzenie. Niektóre sentencje były wypowiadane neutralnie. Komputer radził sobie na podobnym poziomie jak niewyszkoleni ludzie. „Chcieliśmy umieścić nasze modele w realistycznym kontekście i użyliśmy umiejętności przewidywania emocji przez ludzi jako punktu odniesienia. Gdyby modele przewyższyły ludzi, oznaczałoby to, że mogą istnieć wzorce, których my nie jesteśmy w stanie rozpoznać” – tłumaczy dr Diemerling.

Twarz niczego nie ukryje

Naturalnie istnieją też inne sposoby, za pomocą których komputery mogą odczytać ludzkie emocje. Zespół z tajwańskiego Narodowego Uniwersytetu w Kaohsiung opisał niedawno oparty na sztucznych sieciach neuronowych system rozpoznający nastrój człowieka na podstawie analizy jego twarzy. AI została wytrenowana na dużej bazie danych ze zdjęciami twarzy wyrażających różne rodzaje emocji.

„W komunikacji międzyludzkiej wyraz twarzy zawiera kluczowe informacje niewerbalne, które mogą dostarczyć dodatkowych wskazówek i znaczeń istotnych dla komunikacji. Niektóre badania sugerują, że 60–80 proc. komunikacji ma postać niewerbalną. Informacje te obejmują ekspresję twarzy, kontakt wzrokowy, ton głosu, gestykulację i dystans fizyczny. W szczególności analiza ekspresji twarzy stała się popularnym tematem badań” – piszą naukowcy w publikacji, która ukazała się na łamach magazynu „Scientific Reports”.

W swoich eksperymentach osiągnęli oni precyzję sięgającą 83% trafność. Sztuczna inteligencja zwracała przy tym szczególną uwagę na wybrane części twarzy. Szczególnie dużo informacji o emocjach zdradzały, jak się okazało, okolice nosa oraz ust.

Czy AI można zasmucić?

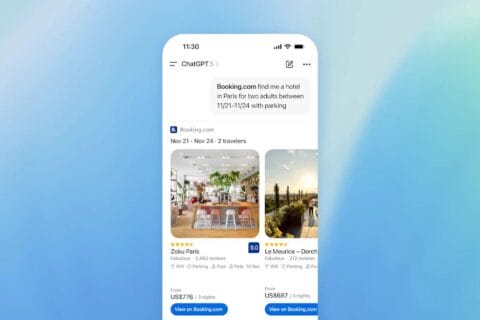

Detekcja emocji to dopiero początek historii. Sztuczna inteligencja staje się coraz bardziej zdolna do ich symulowania. Na przykład firma OpenAI, pionier wprowadzenia GenAI na rynek, udoskonala system, który potrafi to robić w trakcie swobodnej głosowej konwersacji. Chwilami trudno oprzeć się wrażeniu, że rozmawia się z żywą osobą, a do tego całkiem interesującą. Prawidłowo wypowiadanym, typowym dla naturalnego języka zwrotom towarzyszy wyraźne, odpowiednie do kontekstu zabarwienie emocjonalne.

Eksperci OpenAI pokazali możliwości swojej technologii m.in. na promocyjnym materiale, prosząc chatbota o przeczytanie opowiadania. Taki bot może więc opowiedzieć dziecku bajkę, zachęcić do nauki, zmotywować do pracy, podtrzymać na duchu, zażartować czy nawet poflirtować. Rozmowa z nim może stać się dzięki temu dużo bardziej angażująca, satysfakcjonująca i pomocna.

Otoczy nas cyfrowa empatia?

Wszystkie potencjalne zastosowania emocjonalnych AI trudno jest wymienić. W zależności od nastroju właściciela telewizor zaproponuje odpowiedni program czy film, a sprzęt grający – pasującą do chwili muzykę. Samochód zasugeruje zdjęcie nogi z gazu zbyt podenerwowanemu kierowcy. Terapeutyczna AI udzieli lepiej dopasowanej pomocy psychologicznej, dokładniej rozumiejąc nastrój użytkownika. Cyfrowy nauczyciel poprowadzi lekcję, być może nawet lepiej od prawdziwego.

Mówi się o nadchodzącej erze robotów, w tym humanoidalnych, które mają wkraczać w kolejne sfery aktywności człowieka, np. pomagać w pracy czy wspierać osoby starsze lub chore. Takie maszyny będą mogły się stać doskonałym miejscem zastosowania sztucznej inteligencji rozpoznającej i naśladującej ludzkie emocje. Eksperci Allied Market Research szacują, że globalny rynek emocjonalnej AI w 2032 r. będzie wart prawie 14 mld dol.

Lepiej zachować ostrożność

Niektórzy specjaliści wyrażają jednak obawy. Czego się boją? Np. tego, że ludzie zaczną się do maszyn zbyt mocno przywiązywać, za bardzo na nich polegać, zbytnio obniżą swój krytycyzm wobec nich. Może to powodować wzrost podatności ludzi na ewentualne manipulacje ze strony różnych systemów opartych na AI.

To może mieć różne skutki. Już teraz rośnie popularność aplikacji, które tworzą wirtualne awatary mające zastępować partnera czy partnerkę. Ich użytkownicy tłumaczą m.in., że trudno jest znaleźć osobę, która będzie do danego mężczyzny czy kobiety dopasowana, będzie spełniać różne wymagania, a do tego będzie poświęcać drugiej osobie dostatecznie dużo czasu i uwagi.

Aplikacja w telefonie nie ma z wieloma z tych elementów problemu. Może przy tym przybrać postać księcia, milionera czy modelki. Kiedy takie programy zaczną jeszcze grać na ludzkich emocjach, mogą stać się dla nas naprawdę groźne.

Emocjonalna AI może przypominać psychopatę

Ostatnio na łamach pisma „The Conversation” na skrajne aspekty emocjonalnych zdolności maszyn pisała prof. Catrin Misselhorn z Uniwersytetu w Getyndze. W pewnych warunkach emocjonalną sztuczną inteligencję należałoby wręcz porównywać nie do współczującego człowieka, ale wręcz do… psychopaty.

Jak argumentuje ekspertka, tzw. empatia komputerów, nawet jeśli będą one doskonale rozpoznawały ludzkie emocje, będzie miała niewiele wspólnego z prawdziwą empatią. Jedną z cech prawdziwej empatii jest bowiem prawdziwe rozumienie drugiej osoby. Komputery nie są tymczasem zdolne do odczuwania, są tylko tego sztucznie wyuczone.

Sztuczna inteligencja może emocje rozpoznać, może też udawać, że sama je posiada, ale zupełnie nie wie, czym są emocje. Pod tym względem jest właśnie podobna do psychopatów. Tacy ludzie są w stanie intelektualnie rozpoznawać i analizować emocjonalne stany innych osób, co często manipulacyjnie wykorzystują na swoją korzyść. Jednak mają bardzo ograniczoną zdolność odczuwania i empatii.

Prof. Misselhorn zwraca uwagę, że np. AI stosowana w aplikacjach oferujących pomoc psychologiczną będzie traktowała ludzką istotę całkowicie jak neutralny obiekt, niezależnie od tego, jak dobrze emocje człowieka będzie rozumiała i jak umiejętnie będzie symulowała własne.

Opieka AI nad pacjentami przydatna, ale… bądźmy ostrożni

Prof. Misselhorn uważa też, że wspomniane wykorzystanie „empatycznej” AI w opiece nad pacjentami czy w psychoterapii być może należałoby zakwalifikować do kategorii tzw. technologicznego solucjonizmu. To uproszczone i naiwne myślenie, według którego każdy problem da się rozwiązać z pomocą odpowiednio skrojonej technologii.

Ponadto, jak uważa ekspertka, projektowanie sztucznych systemów, które tylko wydają się kimś lub czymś obdarzonym emocjami i empatią, oznaczałoby, że takie urządzenia zawsze mają manipulacyjny charakter. To dobrze udokumentowane zjawisko, że ludzie reagują z empatią na sztuczne systemy, które wykazują pewne ludzkie lub zwierzęce cechy.

Co się stanie, jeśli ktoś zacznie źle traktować „empatyczną” maszynę, zakładając, że to jednak przecież tylko urządzenie? Najpewniej wpłynie to negatywnie na ogólny poziom empatii takiej osoby. Może ona wtedy zacząć zachowywać się gorzej również względem ludzi.

Jako społeczeństwo powinniśmy więc dobrze uważać, podsumowuje prof. Misselhorn, w jakich zakresach chcemy mieć do czynienia z symulującymi emocje i empatię komputerami i robotami. Od tego będzie – być może – zależała nasza przyszłość.

Czytaj też: Roboty będą nam stawiać domy (i w nich mieszkać z nami)

Czytaj też: Robot i człowiek – ścisła współpraca. Będą dobrymi kolegami?

Źródło zdjęcia: Domingo Alvarez E/Unsplash

0 komentarzy

0 komentarzy