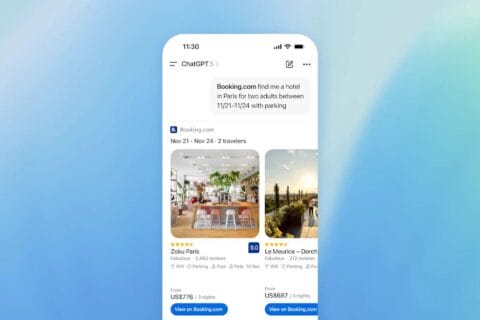

Jak pisze OpenAI, zmiany zaczęły być już wprowadzane. Zapewne przemiana potrwa od kilku dni do kilku tygodni. Na dziś, moje konto ChatGPT wciąż generuje obrazy przy pomocy Dall-E.

Modele dyfuzyjne, czyli jak to dotąd działało

Najpopularniejsze dotąd modele sztucznej inteligencji do generowania grafiki, takie jak Dall-E, Stable Diffusion czy Midjourney, są tak zwanymi modelami dyfuzyjnymi. Sa więc zupełnie inną kategorią modeli AI niż duże modele językowe (LLM).

Jak taki model dyfuzyjny działa? Bierzemy wiele, wiele plików graficznych – zdjęć, grafik, komiksów, reprodukcji obrazów. Do każdego z nich dołączamy etykietę słowną, która mówi co dany plik przedstawia. Następnie model bierze jeden po drugim taki plik i dodaje do niego coraz więcej szumu, aż otrzymujemy obraz podobny do tego, jaki widzimy w telewizorze na częstotliwości, na której nie ma żadnego kanału.

Taki wytrenowany na milionach obrazów model jest w stanie stworzyć obraz, jeśli dostarczymy mu etykietę słowną. Jeśli poprosimy go na przykład o samochód, to model stworzy sobie model szumu. Następnie z tego szumu zacznie wyodrębniać samochód, w jakimś sensie odwracając proces, na którym był trenowany. Trenowanie polega bowiem na dodawaniu szumu w powiązaniu z pewną etykietą, a generowanie – na odejmowaniu szumu w powiązaniu z taką etykietą.

A ponieważ model był trenowany na wielu tysiącach samochodów, to nie dostaniemy jednego z samochodów używanych do wytrenowania modelu, ale swoistą mieszankę takich samochodów. A ponieważ przy generowaniu obrazów, podobnie jak przy generowaniu tekstu, włączone są procesy stochastyczne, to za każdym razem będzie to inny samochód.

Takie modele działają świetnie do generowania zarówno kreatywnych obrazków jak i fotorealistycznych grafik. Mają jednak istotne ograniczenia. Po pierwsze, nie umieją zbyt dobrze liczyć. Po drugie, nie umieją zbyt dobrze pisać.

Ilu może być samurajów?…

Pierwszy z tych problemów pojawia się, jeśli zależy nam na konkretnej liczbie obiektów. Jeśli chcemy ilustrację do „Siedmiu samurajów” Kurosawy, to wolelibyśmy pewnie, by samurajów było siedmiu. Niestety, przy modelach dyfuzyjnych może to wymagać kilku prób. Modele te nieźle radzą sobie z liczbami do mniej więcej trzech. Powyżej tego poziomu mamy loterię.

Drugi problem pojawia się, jeśli do obrazu chcemy dodać tekst. Na przykład chcemy stworzyć komiks z tekstem, stworzyć obraz z drogowskazem do konkretnego miasta, czy po prostu obrazek ulicy z takimi szyldami jak „Bank” czy „Sklep”. Okazuje się, że modele dyfuzyjne nie są zbyt dobre w literkach i mogą wygenerować nam „Baank” albo zlać w jedną dwie leżące obok siebie litery. Oto co stworzył Dall-E poproszony o robota z transparentem mówiącym „DMA”:

Obrazy prosto z GPT-4o, czyli koniec problemów z tekstem

Teraz ma być łatwiej. Obrazy będą generowane przez GPT-4o, a więc model językowy. To powinno istotnie poprawić ich zdolności do wbudowywania tekstu w obraz. I takie zapewnienie dostajemy od OpenAI.

„Obraz jest wart tysiąca słów, ale czasem dodanie kilku słów we właściwym miejscu może podnieść jego znaczenie. Zdolność 4o do łączenia precyzyjnych symboli z grafiką sprawia, że generowanie obrazów staje się narzędziem komunikacji wizualnej”. To pisze spółka w komunikacie ogłaszającym umiejętności graficzne GPT-4o.

I faktycznie – kilka przykładów grafik wygenerowanych przez GPT-4o, w tym również komiksu wskazują, że mamy szansę na o wiele lepszą kontrolę nad tekstem. Kiedy zmiana modelu dotrze również na nasze konta, zobaczymy czy równie dobrze radzi sobie z językiem polskim. OpenAI ostrzega o ograniczeniach obrazków z tekstem wielojęzycznym.

Nie wiemy również, czy zyskamy większą kontrolę nad liczbą obiektów. Modele językowe nie są co do zasady świetnymi matematykami, ale ich umiejętności w tej dziedzinie mocno się poprawiły. Zobaczymy, czy przełoży się to na generowanie grafiki.

Źródło grafiki: Sztuczna inteligencja, model Dall-E 3

0 komentarzy

0 komentarzy