Jak duży będzie nowy Bielik? Jeszcze nie wiemy. Poprzednia wersja Bielika, zbudowana na architekturze modelu Mistral-7B-v0.1, miała 7 miliardów parametrów, była więc modelem dość kompaktowym. Druga wersja ma być większa, ale nie wiemy jeszcze, o ile.

Istotnym ograniczeniem poprzedniej wersji Bielika było dość krótkie okno kontekstowe, czyli ilość danych jakie model jest w stanie przetworzyć „na raz”. Długość okna kontekstowego mierzy się w tak zwanych tokenach – kilkuliterowych ciągach znaków zamienianych przez model na liczby (bo model operuje tak naprawdę na liczbach, nie wyrazach czy literach). To, jak słowa dzielone są na tokeny przez modele OpenAI, można sprawdzić na specjalnej stronie tej firmy. Efekt wygląda tak:

W pierwszej wersji Bielika długość okna kontekstowego wynosiła tylko około 4 tysięcy tokenów. Wystarczająco do krótkiej pogaduszki z modelem, ale za mało np. do zrobienia podsumowania dłuższego dokumentu czy streszczenia rozmowy. Nowy model ma mieć dłuższe okno kontekstowe – od 8 do 32 tysięcy tokenów, w zależności od mocy obliczeniowych, jakimi będą do dyspozycji twórców Bielika. To niewiele w porównaniu z 2 milionami tokentów Gemini 1.5 Pro czy nawet 128 tysięcy GPT-4. Polskiemu modelowi bliżej będzie do 16 tysięcy tokenów, którymi charakteryzował się GPT-3.5.

Większy Bielik i co jeszcze?

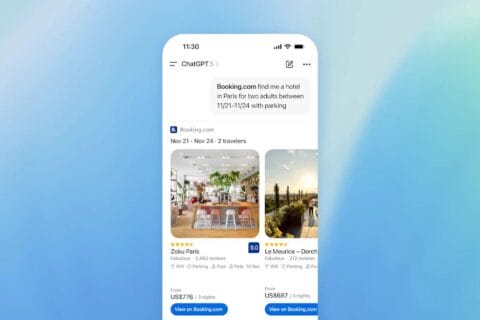

SpeakLeash, który jest projektem tworzącym narzędzia do budowy LLM-ów, pracuje również nad innym projektem: nowym modelem multimodalnym, to znaczy takim, który jest w stanie przetworzyć nie tylko tekst, ale i inne treści, na przykład grafikę czy dźwięk. A więc są to modele, które nie tylko z nami porozmawiają (text-to-text), ale są w stanie na przykład wygenerować obrazek (text-to-image) albo podsumować, co jest na obrazku, który wyślemy w zapytaniu (image-to-text).

Jak zapewnia Sebastian Kondracki – nie wiemy czy nie żartobliwie – SpeakLeash chce z tym modelem podbić Europę. „Chcemy, aby nasze modele stały się produktem eksportowym i podejmujemy wyzwanie, by stać się drugim Mistralem w Europie”.

Mistral to francuski startup AI, najprawdopodobniej najbardziej znany z europejskich twórców LLM-ów, znany na przykład z modeli Mixtral.

Więcej o tym, ile pieniędzy pozyskał na rozwój Mistral przeczytacie w artykule: GenAI to walka gigantów z Doliny Krzemowej? Europejskie start-upy wchodzą do gry!

Źródło zdjęcia: Francesco Veronesi CC BY-SA 2.0

0 komentarzy

0 komentarzy