Możecie zapytać: czym jest mnożenie macierzy i po co ono sztucznej inteligencji? Cóż, obecne modele sztucznej inteligencji to tak naprawdę tzw. głębokie sieci neuronowe, a więc sieci składające się z wielu warstw macierzy liczb. Jak dotąd zakładano, że do działania takich sieci potrzebne jest mnożenie przez siebie macierzy z kolejnych warstw sieci neuronowej. A mnożenie macierzy wymaga dużych mocy obliczeniowych — drogiego sprzętu i dużego zużycia energii elektrycznej.

„Mnożenie macierzy zwykle odpowiada za większą część całkowitego kosztu obliczeniowego dużych modeli językowych” – napisali w artykule „Skalowalne modelowanie języka bez mnożenia macierzy” badacze z UCSC, UC Davies, LuxiTech i Uniwersytetu Soochow.

Badaczom udało się stworzyć nową architekturę dużych modeli językowych, która eliminuje konieczność przeprowadzania operacji mnożenia macierzy. Jakie są jej zalety?

Dlaczego zmniejszenie zasobów zużywanych przez AI jest takie ważne, wyjaśniła szczegółowo Monika Krupska w artykule „Zasoby niezbędne do rozwoju sztucznej inteligencji”.

Nie przegap najważniejszych trendów w technologiach!

Zarejestruj się, by otrzymywać nasz newsletter!

Mniej energii, mniej pamięci — zalety nowej architektury dużych modeli językowych

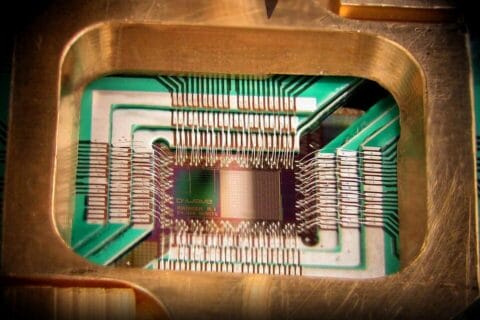

Przede wszystkim, w zaproponowanej architekturze mamy do czynienia ze znacznym spadkiem zapotrzebowania na energię elektryczną. Użyty przez badaczy układ FPGA zużywał tylko 13 W energii dla modelu z 1,3 mld parametrów, podczas gdy na domowym komputerze taki model wymagałby karty graficznej zużywającej do 200 W. Mielibyśmy więc wielokrotne zmniejszenie zapotrzebowania na energię.

Nowa architektura wymaga też mniej pamięci. Badacze oceniają, że trenowanie modeli w nowej architekturze będzie wymagać aż o 61% mniej pamięci. Więc jeśli obecnie wytrenowanie modelu o wielkości 1 mld parametrów wymaga obecnie około 80 GB na karcie graficznej, to w nowej architekturze wystarczy około 32 GB.

Jeszcze lepiej jest przy wykorzystywaniu wytrenowanego modelu do generowania treści — tutaj wymagania co do pamięci spadają dziesięciokrotnie!

Tańsza sztuczna inteligencja — co to oznacza dla Bielika lub PLLuM-a?

Przynajmniej na razie nowa architektura raczej niewiele zmieni dla firm budujących nowe modele — to co zaprezentowali badacze to tylko proof-of-concept na relatywnie małych modelach, z których największy miał 2,3 mld parametrów. Dostępne obecnie polskie modele językowe Bielik (nie wiesz, co to jest polski LLM Bielik? kliknij i przeczytaj!) mają 11 i 7 mld parametrów a należy zakładać, że modele od PLLuM, kiedy się ukażą, będą być może jeszcze większe. Choć badacze sugerują, że ich architektura powinna dać się wyskalować na większe modele, to zapewne poczekamy trochę na odpowiedź, czy tak jest naprawdę.

Ponadto badacze korzystali z programowalnych układów scalonych FPGA, co nie jest najefektywniejszym rozwiązaniem. Należy się spodziewać, że z czasem pojawią się specjalizowane układy scalone implementujące architekturę zaproponowaną w artykule. Prawdopodobnie tańsze od FPGA, które wcale nie są bardzo tanie, np. Altera Stratix IV GX FPGA kosztuje prawie 4500 dolarów.

Jeśli jednak rozwój nowej architektury i sprzętu do niej pójdzie dobrze, to jest to na pewno świetna wiadomość dla projektów AI, takich jak polski Bielik czy otwarty, polski duży model językowy PLLuM. Będzie można zbudować nowe modele za ułamek obecnego kosztu, zarówno w sprzęcie, jak i w rachunku za prąd. To znacznie obniży bariery dla firm, które, w odróżnieniu od OpenAI, nie dostały miliardów dolarów od Microsoftu.

Źródło grafiki: Sztuczna inteligencja, model Dall-E 3

[…] na to pytanie, badacze z UCSC, UC Davies, LuxiTech i Uniwersytetu Soochow stworzyli nową architekturę dużego modelu językowego. Architekturę, w której pewna szczególnie uciążliwa obliczeniowo operacja, zwana […]