Dla przypomnienia, krótkie kalendarium wydarzeń. W piątek, 17 grudnia po południu, firma OpenAI podała, że rada dyrektorów spółki odwołała Sama Altmana z funkcji dyrektora generalnego (CEO). Tego, co potem nastąpiło, chyba nikt się nie spodziewał. Ruszyła karuzela kadrowa i karuzela… spekulacji. I to – karuzela globalna, jak przystało na prawdziwie globalny startup AI z Doliny Krzemowej.

Za zwolnionym z posady Altmanem wstawili się inwestorzy – w tym główny finansujący działalność OpenAI, czyli Microsoft – a także pracownicy. W weekend media spekulowały, że Altman ma zostać przywrócony na swoje stanowisko, Miał negocjować warunki powrotu, jednak już na początku kolejnego tygodnia gruchnęła kolejna wiadomość: Sam Altman przechodzi do Microsoftu.

I gdy wydawało się, że już wszystko się uspokoiło, a eksperci zaczęli zastanawiać się, jakie będą dalsze losy ChatGPT bez lidera tego projektu, to pojawiły się następne kłopoty. Sposób, w jaki rada dyrektorów OpenAI zachowała się wobec Altmana i wytyczony przez nią kierunek zmian, nie spodobał się pracownikom firmy, którzy gremialnie zagrozili odejściem i podążeniem za swoim guru w stronę Microsoftu.

Media donosiły, że 700 na 770 zatrudnionych w OpenAI osób zgłosiło gotowość do pójścia w ślady Altmana. I o ile bez samego lidera pewnie spółka mogłaby sobie jakoś poradzić, o tyle bez większości pracowników – już nie. List z protestem skierowany do zarządu podpisał nawet, jako jeden z pierwszych, dotychczasowy oponent Altmana, główny naukowiec OpenAI, Ilya Sustskever, który złożył na platformie X samokrytykę. Napisał, że żałuje, że wziął udział w aferze z wyrzuceniem Altmana…

Jeśli taka była dramaturgia wydarzeń, to sprawa ostatecznie nie mogła zakończyć się inaczej jak tylko powrotem Altmana na łono macierzystej firmy. Ponownie zasiadł w fotelu dyrektora generalnego OpenAI. A do rady dyrektorów, czyli zarządu spółki, zostały powołane inne osoby.

Ogon zamerdał psem.

Kto ma pieniądze ten ma władzę? Nie w OpenAI

Przy okazji całego tego zamieszania, pojawiło się pytanie: jak to właściwie możliwe, że największy inwestor spółki, czyli Microsoft, który wyłożył na OpenAI ok. 10 mld dolarów – nie miał wpływu na to, co się w niej dzieje? Rozłóżmy więc tę sprawę na czynniki pierwsze.

Zacznijmy od tego, że to nie jest tak, że do OpenAI wpłynęło 10 mld dolarów. Inwestycja Microsoft jest rozłożona na raty, a spora część tej kwoty jest rozliczona w mocy obliczeniowej, którą informatyczny gigant udostępnia twórcom ChatGPT. Po co ta moc? Na przykład na trenowanie kolejnych wersji sztucznej inteligencji – ale o tym za chwilę.

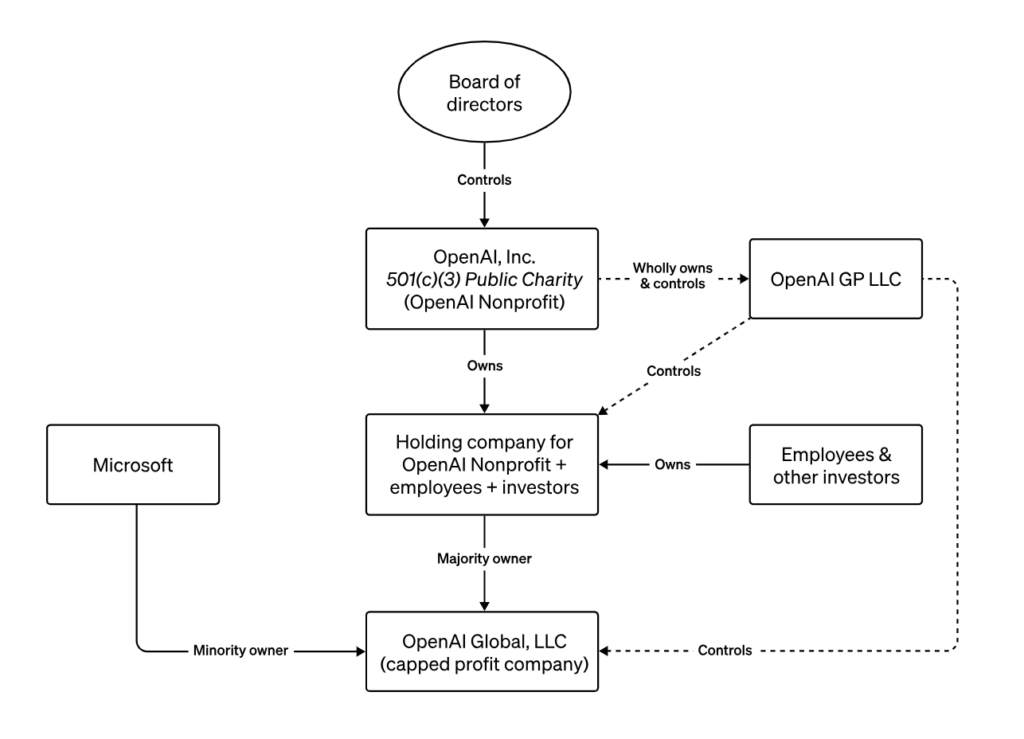

Kolejną kwestią jest struktura korporacyjna. OpenAI to nie zawsze znaczy to samo. Ta nazwa używana jest jako skrót myślowy – tak naprawdę bowiem to słowo występuje w nazwie kilku podmiotów. Jako pierwszy podmiot zostało powołane OpenAI Nonprofit. Stało się to w 2015 r. i Altman był jednym ze współzałożycieli tego badawczego startupu.

Jak sama nazwa wskazuje, jest to organizacja o charakterze badawczym, nastawiona nie na zysk, ale na rozwój sztucznej inteligencji w sposób bezpieczny i korzystny (w domyśle: dla ludzkości). Jej celem – jasno wyartykułowanym – jest stworzenie AGI (artificial general inteligence), czyli sztucznej inteligencji ogólnego zastosowania.

Czym jest AGI, czy będzie przyjacielem ludzkości, czy sprowadzi na nas zagładę, wyjaśnia prof. Growiec w minicyklu trzech artykułów, z których każdy porusza odrębne kwestie związane z rozwojem AGI.

Pewną zaszłością strukturalną, ale i świadomym celem założycieli startupu jest to, że to rada dyrektorów OpenAI Nonprofit sprawuje kontrolę nad działalnością wszystkich pozostałych podmiotów z grupy – niezależnie od tego, ile kto ma udziałów. Gdzie w takim razie Microsoft? Gigant technologiczny dołączył do OpenAI później i musiał zadowolić się takim miejscem, jakie mu wyznaczono. Ale – po kolei.

Gałąź biznesowa, bo potrzebne pieniądze na rozwój

Kierownictwo OpenAI po kilku latach badań zorientowało się, że w strukturze czysto badawczej może być ciężko pozyskać najlepsze talenty na rynku. Dlaczego? Ponieważ badania nad sztuczną inteligencją prowadzą właściwie wszystkie większe firmy technologiczne, a także niezliczone startupy. Potrzebne są do tego coraz większe pieniądze.

Standardem w tej branży jest, by pracownicy otrzymywali udziały w spółkach, dla których pracują. W ten sposób gotowi są na pracę za niższe wynagrodzenie, za to dużo bardziej zależy im na sukcesie firmy – jeśli rozwijany produkt znajdzie nabywców, szybko mogą stać się milionerami dzięki posiadanym akcjom.

Dlatego też powołano OpenAI Global LLC, czyli spółkę, która mogła zupełnie rynkowo emitować akcje, pozyskiwać inwestorów i prowadzić działalność komercyjną. Udziałowcami tego podmiotu stali się pracownicy, inni inwestorzy, a w końcu – także Microsoft. Ta tzw. biznesowa gałąź czy noga firmy została rozwinięta właśnie przez Altmana.

Gigant z Redmont ma 49% udziałów, drugie tyle jest rozproszone między pozostałych interesariuszy, zaś 2% akcji jest w posiadaniu OpenAI Nonprofit. Wciąż to jednak rada tego podmiotu podejmuje wszystkie ważne decyzje. Warto też zaznaczyć, że OpenAI nie jest firmą giełdową – jej transparentność i sposób komunikacji jest więc kwestią decyzji zarządu, a nie obowiązku regulacyjnego.

Co ma tak cennego OpenAI?

Żeby odpowiedzieć na tak zadane pytanie, warto krótko wyjaśnić, co składa się na sztuczną inteligencję – w tym rozumieniu, o którym wszyscy ostatnio mówią. Sieć neuronowa, algorytm uczący i środowisko – te trzy składniki są potrzebne, by stworzyć sztuczną inteligencję w ramach uczenia maszynowego. Czym one są?

Na sieć neuronową składają się połączenia między różnymi działaniami, które mogą być wykonywane. W ramach trenowania takiej sieci poszczególnym połączeniom przypisywane są różne „wagi” – im skuteczniejsze jest dane działanie dla osiągnięcia celu, tym wyższa waga.

Środowiskiem są dane, na których sieć neuronowa jest trenowana. Może to być gra w szachy, może być zbiór tekstów lub obrazów. To także wszelkie zasady oraz system kar i nagród, które mają wskazywać kierunek uczenia się.

Algorytm uczący łączy zaś te dwa wcześniejsze elementy. To on ocenia, na ile podejmowane próby przybliżają trenowaną sieć neuronową do wyznaczonego celu i przypisuje odpowiednie wagi do połączeń.

A jak to właściwie działa?

Wyobraźmy sobie, że chcemy stworzyć sztuczną inteligencję, która naśladuje przechodzenie zwierząt przez przeszkody terenowe. Do środowiska zaliczymy więc samą lokalizację (np. kładkę nad rzeczką), zasady (można iść w przód, w tył lub na boki) oraz system kar i nagród (premia za przejście na drugą stronę, kara za skąpanie się w rzeczce). Sieć neuronowa, czyli nasz trenowany agent (dajmy mu nazwę: „Pieski_Małe 2”) będzie tresowana, tfu, trenowana przez algorytm uczący się.

Agent będzie wykonywał dostępne działania losowo, na podstawie przypisanych wag do poszczególnych połączeń. Jeśli zrobi krok do przodu, to przybliży go to do nagrody, a algorytm przyzna większą wagę takiej akcji – to znaczy, że rośnie prawdopodobieństwo, że w kolejnej próbie znowu pójdzie do przodu. Może jednak wylosować ruch w bok – a wtedy PM2 wyląduje w rzeczce i otrzyma karę. Algorytm zapisze w sieci neuronowej, żeby w przyszłości unikać takich działań.

To oczywiście ogromne uproszczenie, ma jednak osobom, które nie są specjalistami od uczenia maszynowego (takim jak ja) przynajmniej dać wyobrażenie, jak to działa.

Od czego zależy skuteczność finalnej sztucznej inteligencji? Od każdego z tych elementów. Dobrze zaprojektowana sieć neuronowa pozwoli na efektywniejsze uczenie się. Liczba przeprowadzonych iteracji (powtórzeń) ćwiczenia – może udoskonalić wagi połączeń sieci. Odpowiednio obszerne środowisko, zdefiniowanie kar i nagród oraz zasad nim rządzących – odwzorować rzeczywistość, w której będzie potem ta sztuczna inteligencja wykorzystywana.

Trzeba też zaznaczyć – po milionie, miliardzie czy bilionie powtórzeń treningowych, uczenie się kończy. Wagi w sieci neuronowej są „zamrażane” i przechodzą w tryb „tylko do odczytu”. Wykorzystywanie takiej sieci już jej nie uczy – co nie zmienia faktu, że dane pochodzące z jej użycia mogą stać się częścią środowiska (czyli „wkładu”) do kolejnej wersji.

Co jest czym w ChatGPT?

Czym w tym układzie jest słynny ChatGPT? Siecią neuronową, na której oparto aplikację. Środowiskiem są m.in. dane tekstowe, na których ją trenowano. W przypadku ChatGPT 3 było to 570 GB danych, zawierających 300 miliardów słów. W przypadku kolejnej, czwartej wersji, sieć neuronową uczono na pięć razy większym zbiorze.

Algorytm uczący opiera się na otwartym modelu, jednak od pewnego czasu zmiany wprowadzane przez OpenAI nie są ujawniane. Jednocześnie nie są objęte patentem. Dlaczego? Ponieważ wystąpienie o patent wiąże się z koniecznością ujawnienia wynalazku. A w informatycznym świecie dużo trudniej ścigać kogoś za wykorzystanie opatentowanego wynalazku.

Dlatego też algorytmy wyszukiwarki Google, czy te decydujące o tym, które posty podpowiada użytkownikom Facebook, czy też te, które sugerują kolejne klipy na TikToku – są tajne. Gdyby były opatentowane, to każdy, kto chciałby grać przeciwko nim, miałby ułatwione zadanie – nawet bez naruszania patentu.

Cóż więc tak wyjątkowego ma OpenAI, czym nie dysponuje konkurencja? Zarówno w zakresie algorytmu, sieci neuronowych czy środowiska, każdy z gigantów mógłby dorównać małemu w sumie startupowi.

ChatGPT – dlaczego tak wyjątkowe?

Pytałem w ostatnich dniach ludzi z tego sektora – programistów, specjalistów od sztucznej inteligencji – na czym polegała wyjątkowość ChatGPT?

„Generalnie to, co OpenAI zrobiła dobrze, to doprowadziła ten model do jakości „wow” z jakości „o ciekawe”. LLM [Large Language Model – czyli model AI] firmy Google nie zrobił „wow”, a pracowało nad nim więcej ludzi, a mieli dużo zasobów i czasu” – usłyszałem.

I to jest nauka, którą powinni przyswoić sobie wszyscy przedsiębiorcy. Nie tylko ci z branży technologii, choć dla innowacyjnych sektorów to szczególnie ważne. Choć obserwujemy gwałtowny rozwój sztucznej inteligencji, to jednak ludzie – i to konkretni ludzie – i ich talent decyduje.

Krąży żart, że korporacyjny project manager to ktoś, kto uważa, że skoro ciąża jednej kobiety trwa dziewięć miesięcy, to dziewięć kobiet upora się z tym w miesiąc. Tak to nie działa.

Nieograniczone zasoby z pewnością pomagają w tworzeniu innowacji – to brak pieniędzy zmusił założycieli OpenAI do uruchomienia komercyjnej odnogi – ale nie gwarantuje sukcesu. Odpowiednia motywacja pracowników, lider, wizja – to te czynniki mogą sprawić, że z ciekawostki jakaś innowacja przekształci się w zmieniającą świat technologię.

Powodów, dla których to nie Google ani Facebook wygrywają ten wyścig, jest oczywiście więcej. Duże korporacje nie są skłonne do zmian – zwłaszcza, gdy ich obecne modele biznesowe przynoszą krociowe zyski.

Jest potencjał rozwoju AI poza OpenAI?

Czy samo przejście Sama Altmana oraz większości załogi OpenAI byłoby równoznaczne z tym, że Microsoft mógłby odtworzyć u siebie ChatGPT (który – przypomnijmy – obecnie wykorzystuje w swoich produktach, jednak na zasadzie licencji od OpenAI)?

Generalnie tak, choć zajęłoby to sporo czasu. Ludzie, z którymi rozmawiałem mówili, że w ciągu 3-6 miesięcy możliwe byłoby odtworzenie tego, co udało się wypracować w OpenAI. Jednak mowa głównie o ten technologicznej, infrastrukturalnej części – natomiast cały ten „fine tuning”, czyli dopieszczanie aplikacji, jej użyteczności, tego efektu „wow” – tutaj gwarancji nie ma.

Wniosek dla przedsiębiorców? Dbajcie o swoich pracowników, dopieszczajcie ich, jak tylko możecie. Czy to topowi programiści tworzący sztuczną inteligencję, czy to pracownicy infolinii – na razie to od jakości pracy i silnej motywacji ludzi w firmie zależy powodzenie biznesu.

A na razie my wszyscy, wpatrzeni w ekrany laptopów i smartfonów, oglądajmy dalej pasjonujące story o OpenAI. Zamieszanie kadrowe – na razie – minęło, a praca nad kolejnymi wersjami AI – trwa. Co dalej? Będziemy opowiadać na łamach HomoDigital.

Czytaj też: Wczoraj zmienił się świat. Przełomowa aktualizacja ChtaGPT

Źródło zdjęcia: Growtika/Unsplash

0 komentarzy

0 komentarzy