Pod koniec stycznia ukazał się model DeepSeek-R1 – otwarty chiński model rozumujący, który dorównywał najlepszym dostępnym wówczas modelom od OpenAI. Wytrenowanie tego modelu kosztowało ułamek nakładów dotychczas ponoszonych na trenowanie modeli amerykańskiej konkurencji. Rynki przeszły wstrząs, zaczęto zadawać pytania o wyceny największych startupów AI, a kurs Nvidii do dziś nie wrócił do poziomów sprzed debiutu R1.

Ale R1, mimo że jest modelem otwartym, ma swoje wady. Przede wszystkim, jest to prawdziwe monstrum z 671 mld parametrów, które nie zmieści się na żadnym komputerze i do uruchomienia wymaga klastra. Możemy oczywiście skorzystać z chatbota DeepSeek, czy to przez przeglądarkę, czy to przez apkę na smartfonie. Ale, jak już pisaliśmy, dane wyciekają z DeepSeeka strumieniami. Teraz dostajemy jednak alternatywę.

Model QwQ – mały, a dużo może

QwQ-32B, bo taka jest pełna nazwa modelu, to dziecko badaczy chińskiego giganta e-commerce Alibaby. Z tego samego labu wyszły wcześniej modele Qwen, uważane za jedne z najlepszych otwartych dużych modeli językowych. Teraz dostajemy od nich model rozumujący.

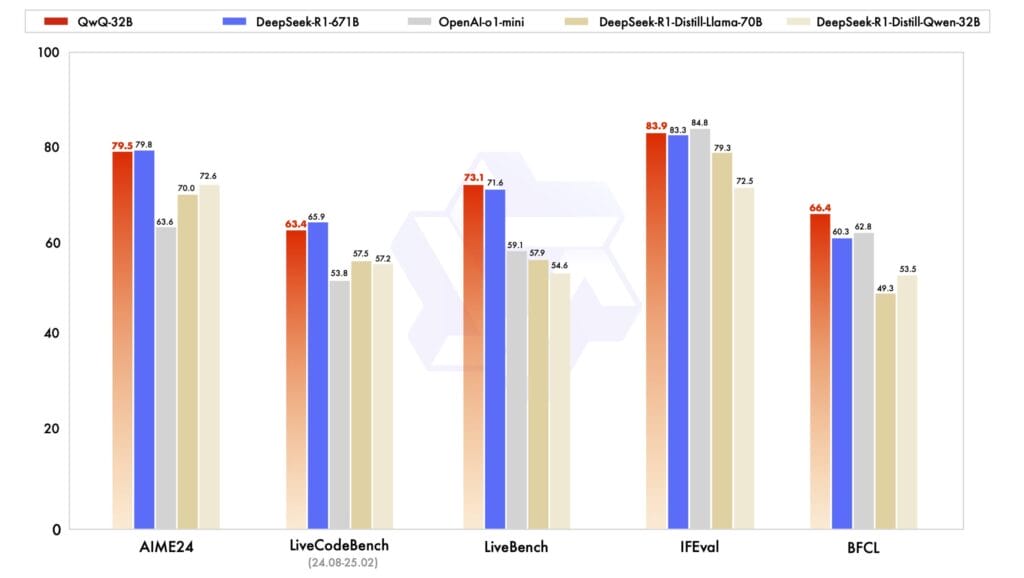

Podstawową zaletą QwQ jest to, że osiąga on podobne wyniki benchmarków jak DeepSeek-R1, a jednocześnie jest to relatywnie niewielki model o 32 mld parametrów. Jak widzimy, mniejsze wersje DeepSeeka porównywalne rozmiarem z QwQ są od niego istotnie gorsze.

Z kolei, o ile o zainstalowaniu na swoim komputerze największej wersji DeepSeeka mogliśmy tylko pomarzyć, to skwantyzowaną wersję modelu od Alibaby jesteśmy w stanie zmieścić na komputerze z 32 GB pamięci RAM. Śmigać nie będzie, ale do podstawowych testów wystarczy.

Niestety, jeśli byśmy chcieli zmieścić go na karcie graficznej, by chodził nam (o wiele) szybciej, to musimy zainwestować w kartę RTX 5090. A to wydatek rzędu 17-18 tysięcy zł.

Jeśli nie chcemy męczyć naszej maszyny, to możemy skorzystać z chata Qwen, zaznaczając opcję Thinking (QwQ). Oczywiście musicie pamiętać, że choć podejście do cyberbezpieczeństwa w Alibabie jest pewnie o wiele poważniejsze niż w DeepSeeku, to nadal trzeba się liczyć z tym, że cokolwiek napiszecie, może zostać przejrzane przez funkcjonariuszy państwa chińskiego. Taki urok korzystania z chińskiej AI.

Ja zaryzykowałem, na wszelki wypadek nie wpisując politycznych promptów. Pierwsze wrażenia? Jest bardzo szybki. I mówi (pisze) po polsku, choć jest to polski odrobinę „drewniany”. Sam model „myśli” po angielsku i, podobnie jak DeepSeek-R1 a w odróżnieniu od o1 od OpenAI, pokazuje nam swój bieg myślenia. Jednak końcowa odpowiedź jest udzielana po polsku – oczywiście jeśli po polsku zostało zadane pytanie.

Programiści, którzy chcieliby wykorzystać model przez API, mogą skorzystać z oferty Hyperbolic Labs. Bez wścibskich oczu chińskich towarzyszy.

A może tak rozumujący… Bielik?

Pojawiające się co i raz nowe modele rozumujące sprawiły, że się trochę rozmarzyłem. A może by tak powstał „rozumujący” polski model? Taki, który mówiłby piękną polszczyzną i nie operowałby nieznośnymi kalkami językowymi z angielskiego. A jednocześnie taki, który by miał zalety modeli rozumujących.

Bielik wydaje się dobrym kandydatem do przemiany w model rozumujący. Świetnie mówi po polsku i ma jedne z najlepszych osiągów wśród modeli podobnej wielkości. Na razie, jak słyszymy, twórcy Bielika chcą tworzyć Sójkę, model do moderacji treści. Ale może dałoby się coś jeszcze więcej wycisnąć z superkomputera Cyfronetu i stworzyć model rozumujący…

Źródło grafiki: Sztuczna inteligencja, model Dall-E 3

0 komentarzy

0 komentarzy