Na czym polega innowacja Groqa? Na specjalnym procesorze nazwanym przez firmę procesorem językowym (Language Processing Unit, LPU). W odróżnieniu od procesorów graficznych (GPU), które są szeroko stosowane obecnie w generatywnej sztucznej inteligencji, LPU zostało specjalnie zaprojektowane do danych tekstowych, nie zaś graficznych.

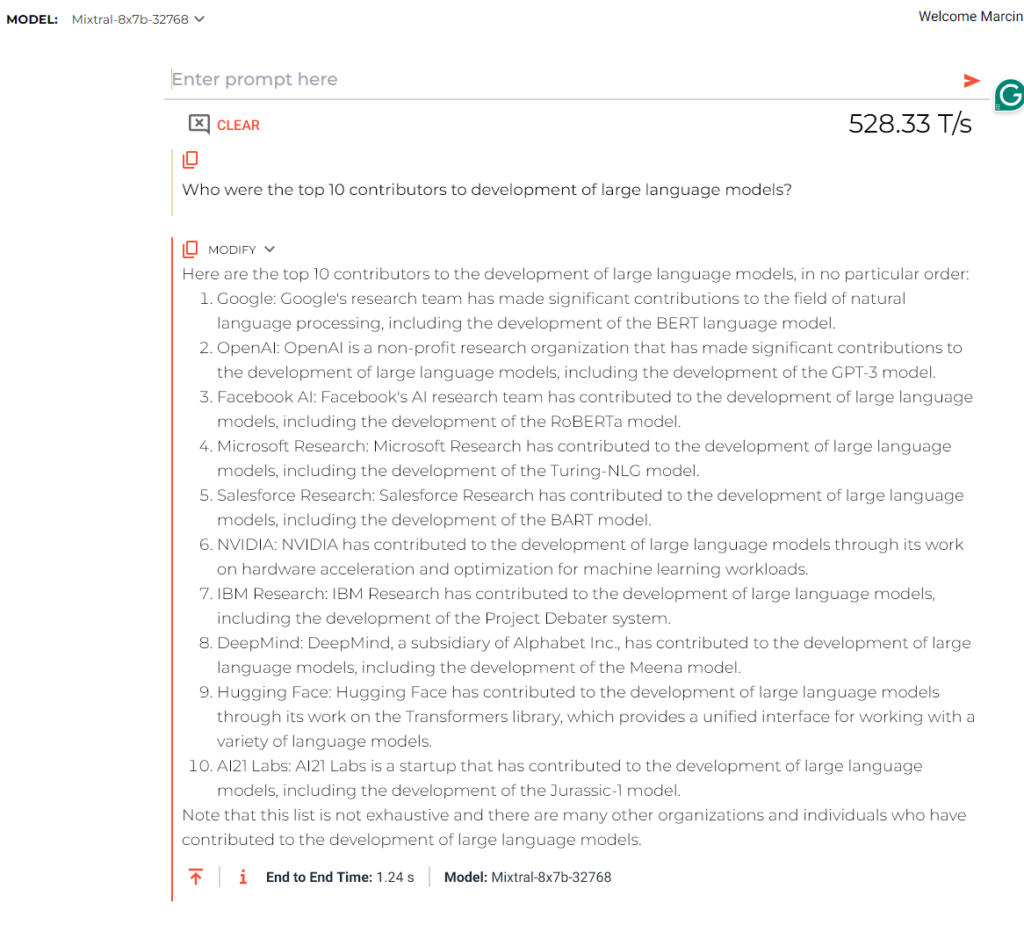

Jak szybki jest Groq? Sami możecie to wypróbować na stronie firmy. Korzystając z modelu Mistral 8x7b, uzyskałem odpowiedź na około 1800 znaków (287 słów) w ciągu zaledwie – jak widać na ilustracji – 1,24 sekundy.

Moje doświadczenia z tym modelem Mistrala na Hugging Face pokazywały istotnie dłuższy czas odpowiedzi, nawet gorszy niż to, co oferuje (no, trzeba szczerze powiedzieć, lepszej infrastrukturze) ChatGPT. Według jednego z testów ChatGPT byłby 13 razy szybszy niż teraz, gdyby używał technologii Groqa.

Czy LPU od Groqa zastąpi karty od Nvidii?

Niestety nie, procesory Groqa służą wyłącznie inferencji. Czyli – udzielaniu odpowiedzi na pytania przez już wytrenowany model. Nie nadają się jednak do trenowania modeli. Nie zmienia to jednak faktu, technologia Groqa mogłaby się przyczynić do szybszego budowania kolejnych modeli generatywnej sztucznej inteligencji. Odciążając przy okazji oparte o procesory Nvidii centra danych do obsługi zapytań klientów

A Nvidia nie przestaje zadziwiać – popyt na jej karty graficzne ze strony firm rozwijających sztuczną inteligencję wyniósł wyniki spółki na nowe szczyty.

Na razie Groq wydaje się jednak bardzie skupiać na kierowaniu swojej oferty dla startupów. Właśnie w pełni otworzył dostęp programistyczny do swojej infrastruktury przez tzw. API. Chwilowo dostępne do użycia są modele od Mistrala i Mety (LLama 2).

Groq jest bardzo optymistyczny, jeśli chodzi o popularność swojej technologii wśród startupów. Według założyciela i prezesa Jonathana Rossa, Groq będzie „infrastrukturą, którą będzie wykorzystywało większość startupów pod koniec tego roku”.

Startupy będzie zachęcać niższa niż gdzie indziej cena i wydajność infrastruktury. Ross wierzy, że pod koniec 2024 roku Groq będzie miał wydajność – mierzoną w tak zwanych tokenach, a więc fragmentach słów – jaką OpenAI miała pod koniec 2023 roku.

Źródło grafiki: Sztuczna inteligencja, model Dall-E 3

0 komentarzy

0 komentarzy